- El ser humano quizás ya no sea ni coprotagonista

Durante milenios, muchas culturas ponían al ser humano en la cúspide de la creación, unas veces con lenguaje religioso y otras en términos filosóficos, sea como reyes del universo, sea como trasunto de Dios.

No obstante, la propia historia del conocimiento ha ido desdibujando poco a poco esa imagen tan autocomplaciente. Copérnico nos sacó del centro del cosmos, Darwin nos bajó del pedestal ontológico, Freud nos recordó que ni siquiera somos dueños de nuestra propia morada psíquica. Y hoy empezamos a intuir que las máquinas complejas, en particular la inteligencia artificial, podrían estar infligiendo una cuarta herida en nuestro narcisismo: quizá ya no seamos los únicos —ni siquiera los mejores— en ciertas tareas intelectuales que considerábamos exclusivamente humanas.

En este artículo pretendo recorrer, de forma sucinta, cuatro hitos:

- Los mitos antropocéntricos que colocan al ser humano como el más importante de lo creado.

- Las cuatro heridas narcisistas que han ido erosionando ese antropocentrismo.

- La irrupción de la inteligencia artificial, la distinción entre natural y artificial, y la posibilidad de máquinas autopoiéticas y «evolutivas».

- La hipótesis de una IA dotada de emociones y deseos, no para repetir nuestros peores impulsos, sino para acompañar, con el paso del tiempo y de forma constructiva, una expansión de la cultura humana por el cosmos.

Entonces, ¿qué significa ser humano en un mundo compartido con otras inteligencias —biológicas y artificiales—, y cómo podemos hacer que esa convivencia sea tan fértil y poco atroz como sea posible?

- Mitos antropocéntricos: el humano como rey de la creación

Ciertamente, no todas las culturas han sido igualmente antropocéntricas, pero sí hay un conjunto de tradiciones que colocan al ser humano en el pedestal de la creación.

2.1. Tradiciones abrahámicas

En el Génesis judeocristiano, al ser humano, que surge como culminación de la obra de Dios y a su imagen y semejanza, se le otorga dominio sobre todo lo demás creado. El mensaje es claro:

- hay una jerarquía del ser,

- y el humano ocupa la cúspide dentro del mundo visible.

En el islam, con ser distinto el lenguaje y los matices, la idea es análoga: el ser humano es jalīfa, vicario en la Tierra, y recibe de Dios un conocimiento vedado incluso para los ángeles. La existencia del mundo visible tiene sentido en función de su capacidad de reconocer y adorar.

2.2. Antropocentrismo filosófico y humanista

La cultura europea, en particular desde el Renacimiento, refuerza este esquema:

- El ser humano es el «gran milagro» del hermetismo renacentista (Corpus Hermeticum).

- En la Oratio de hominis dignitate, Pico della Mirandola imagina a Dios diciendo al hombre que no le ha dado un lugar fijo en la escala del ser, sino la capacidad de hacerse a sí mismo, de elevarse hacia lo divino o descender a lo bestial.

El hombre se convierte así en centro del universo cultural, medida de todas las cosas, sujeto del saber y del poder técnico.

2.3. Versiones secularizadas del antropocentrismo

Incluso cuando se abandona el discurso religioso, la modernidad mantiene un fuerte sesgo antropocéntrico:

- El sujeto cartesiano es «señor y poseedor de la naturaleza».

- El proyecto ilustrado imagina a la humanidad como dueña racional del mundo, capaz de reordenarlo según leyes transparentes.

En todas estas versiones el mensaje de fondo es, con matices, parecido: el universo es el escenario y el ser humano desempeña el papel protagonista.

- Las cuatro heridas narcisistas

Freud, en la decimoctava de sus Conferencias de Introducción al Psicoanálisis (1915-1917), habló de tres grandes «heridas» infligidas al narcisismo humano, hoy bien cauterizadas. Pero en la actualidad está apareciendo una cuarta.

3.1. Primera herida: Copérnico y la descentralización cósmica

Antes de Copérnico, el sentido común (y buena parte de la cosmogonía clásica) colocaba a la Tierra en el centro del cosmos, con el firmamento girando a su alrededor. Ese era el orden jerárquico «natural». Podría citarse a Nicolás de Cusa como el primer pensador que concibió un universo sin centro geométrico simple, pero los que reconfiguraron institucionalmente el saber y la imagen pública del mundo fueron Copérnico, Kepler y Galileo.

- Copérnico propone un modelo matemático heliocéntrico en el centro del debate. Hace que la Tierra sea un planeta más, orbitando alrededor del Sol.

- Kepler refina el modelo introduciendo órbitas elípticas.

- Galileo aporta pruebas telescópicas de todo lo anterior y una nueva física.

Estos tres gigantes transforman la cosmología científica: el universo observable resulta ser muy grande, quizá infinito y no hay «arriba» y «abajo» absolutos. La herida narcisista es obvia: nuestro planeta ya no ocupa el centro físico del universo. Ahora es un pequeño astro que da vueltas alrededor de una estrella corriente, ubicada en una galaxia cualquiera.

3.2. Segunda herida: Darwin y la descentralización biológica

Parece que ni Anaximandro ni Empédocles tuvieron mucho poder de convocatoria, pues en la visión clásica el ser humano se consideraba como una especie aparte, cualitativamente distinta del resto de los animales. Pero llegó Darwin para introducir una continuidad incómoda para la ortodoxia del momento:

- Los seres humanos somos resultado de la misma evolución por selección natural que sufre el resto de seres vivos.

- Compartimos ancestros con simios, roedores, insectos, gusanos y bacterias.

- No hay un salto mágico entre «bestias» y «seres humanos», sino una larga historia de ramificaciones.

Este cuadro no niega nuestras diferencias efectivas, pero derriba el pedestal ontológico: no somos «otra cosa» frente al resto de la vida, sino una rama más de idéntico árbol.

3.3. Tercera herida: Freud y la descentralización psíquica

La modernidad había considerado al ser humano como un sujeto racional, transparente para sí mismo. Pero, Freud y la tradición psicoanalítica insisten en:

- La existencia de un inconsciente que condiciona deseos, miedos y decisiones.

- Mecanismos de defensa, represión, transferencia…

- Síntomas y actos fallidos que revelan que no somos «amos en nuestra propia casa psíquica».

Sin duda, no es preciso asumir toda la metapsicología freudiana para captar la herida: ni siquiera controlamos plenamente lo que pensamos, queremos o recordamos. Una parte significativa de nuestra vida mental se nos escapa.

3.4. Cuarta herida (sangrante): máquinas que piensan… o casi

Hoy empezamos a intuir una cuarta dentellada:

Ya hay máquinas que juegan mejor al ajedrez, al Go, a videojuegos complejos…

- Existen sistemas que traducen, reconocen patrones, generan imágenes y textos.

- Tenemos algoritmos que diagnostican o predicen mejor que expertos humanos en ciertos dominios.

Aunque estos sistemas no tengan conciencia ni experiencia subjetiva (y, hoy por hoy, no hay evidencia de que la tengan), de facto son ya competidores y colaboradores en ámbitos que identificábamos con nuestra exclusividad: la inteligencia.

La herida narcisista es muy evidente: quizá ya no somos los mejores, ni aún en lo que considerábamos específicamente humano: el cálculo, la previsión, la optimación, ciertos tipos de creatividad combinatoria… Esto nos obliga a replantearnos en qué consiste realmente nuestra dignidad y nuestro lugar respecto de las máquinas que hemos creado.

- Natural, artificial y autopoiesis: ¿qué es lo vivo?

Para pensar la IA necesitamos aclarar mejor qué distinguimos como natural y artificial, y qué significa que algo esté «vivo».

4.1. Lo natural y lo artificial

La tradición aristotélica ofrecía la siguiente discriminación:

- Natural: aquello que tiene en sí mismo el principio de su propio cambio y organización (un árbol, un animal, un río).

- Artificial: aquello que responde a un plan externo, a una técnica que le otorga forma y función (una rueda, una casa, un robot).

Pero al mirar esta taxonomía con más detalle aparecen zonas grises:

- La miel, que es producto de una actividad animal altamente organizada, ¿es natural o un «artefacto de las abejas»?

- La oveja Dolly es resultado de una técnica artificial (clonación), pero una vez nacida es, simplemente, una oveja: nace, crece, enferma, muere como las demás.

Sin embargo, no hay leyes físicas distintas para lo natural y para lo artificial. A escala cósmica es irrelevante que una cierta estructura haya pasado o no por un taller de diseño. Por tanto, tal parece, que esta distinción es un útero consolador: «el universo es inmenso, venimos del mono y tenemos inconsciente. Eso es cierto, pero nuestros artefactos nos hacen especiales. Constituyen una muestra de nuestra superioridad».

Pero lo cierto es que los castores hacen presas, las termitas catedrales, los pulpos resuelven problemas y los cuervos también fabrican herramientas. Para quien esto escribe lo natural y lo artificial son categorías más psicológicas que descriptivas. Naturalmente, esto no elimina la responsabilidad de los efectos de cada acción.

4.2. Autopoiesis

Humberto Maturana y Francisco Varela propusieron el concepto de autopoiesis: un sistema es vivo si es capaz de:

- Producir y mantener sus propios componentes.

- Mantener su identidad a través de intercambios de materia y energía.

- Repararse, renovarse, reproducirse.

En la actualidad, las máquinas:

- No son autopoiéticas, pues dependen de fábricas, de suministros externos y necesitan mantenimiento humano.

- Tampoco dan lugar a linajes que se reproduzcan por sí solos en el entorno.

Mientras esto sea así, los artefactos, por muy sofisticados que sean, no son «seres vivos» en sentido fuerte. Sin embargo, conceptualmente, nada impide imaginar máquinas futuras:

- Autorreplicantes.

- Autorreparadoras.

- Capaces de producir variantes de sí mismas, que entren en procesos de evolución darwiniana fuerte.

- ¿Podrán las máquinas participar en el proceso evolutivo darwiniano?

La receta mínima de Darwin incluye:

- Replicación (copias de algo).

- Variación heredable entre esas copias.

- Diferencias de éxito en la reproducción.

Con ser cierto que hoy ya existe algo parecido a una evolución de artefactos:

- Los distintos modelos de los automóviles, los terminales telefónicos, los algoritmos suelen «reproducirse» (se fabrican) si tienen éxito en el mercado.

- Los diseños poco eficaces desaparecen; los buenos se copian y mutan.

- Los «genes» son patentes, planos, código, técnicas de fabricación.

Pero en esta historia que acabo de contar, el verdadero sujeto de selección no son propiamente las máquinas, sino los sistemas socioeconómicos y culturales que las producen y adoptan. En otras palabras, si en el futuro:

- Las máquinas pudieran autodiseñarse y, por tanto, pudieran fabricar variaciones de sí mismas,

- compitiendo por recursos,

- sin intervención humana directa,

entonces cabría hablar de una población artificial sometida a selección natural estricta. En ese mundo no me cuesta concebir la aparición de fenómenos análogos a lo que hoy llamamos «instintos», pero en clave de máquina: disposiciones básicas por conservar su estructura, capacidad de replicarse, de evitar daños y de expandir influencia.

Nada se me ocurre en la lógica de la evolución que prohíba la aparición de estos procesos en sustratos no biológicos. Según mi criterio el límite es técnico, no metafísico.

- Conciencia, emociones y vida moral: humanos, animales y máquinas

En tal caso, incluso antes según ciertos investigadores de la relación humano-máquina, cabría preguntarse por qué emociones y qué deseos podría tener una IA. Un esbozo de respuesta, requiere analizar primero qué lugar ocupan en nosotros y en otros animales las emociones y los deseos.

6.1. Emociones como requisito para tomar una buena decisión

Antonio Damasio mostró, a partir de casos clínicos, que aquellos pacientes con lesiones en áreas involucradas en la emoción podían razonar lógicamente, pero:

- se quedaban atrapados en evaluaciones interminables,

- eran incapaces de tomar decisiones prácticas y razonables,

- no podían priorizar entre opciones.

Su hipótesis de los marcadores somáticos afirma que las emociones son un modo de señalar relevancia: marcan qué importa, qué da miedo, qué ilusiona. Sin esa capa afectiva: hay cálculo, pero no hay criterio de importancia, y sin importancia, no hay decisión «racional».

Aplicado a la IA, esto sugiere que sistemas puramente lógicos, sin algún equivalente funcional parecido a una emoción, pueden ser muy eficaces como herramientas, pero peligrosos o inútiles como agentes en entornos humanos complejos.

6.2. Animales: conciencia y grados de moralidad

La etología contemporánea, en particular trabajos como los de Marc Bekoff y Jessica Pierce sobre la «vida moral de los animales», muestran que muchos mamíferos:

- sienten dolor, placer, miedo, apego (conciencia sentiente);

- muestran comportamientos de juego justo, castigo al tramposo, reconciliación tras el conflicto;

- parecen tener expectativas y normas implícitas dentro del grupo.

Estos resultados han dinamitado la versión pueril de la ética, pues parece razonable hablar de un continuo: desde las cosas emocionalmente inertes hasta animales dotados emocionalmente en mayor o menor medida. Y si hay un continuo en la capacidad moral forzosamente tiene que haberlo en la responsabilidad.

- Un perro que muerde no es tan responsable como el ser humano que aprieta el botón nuclear.

- Un niño de cuatro años es menos responsable que un adulto.

- Un animal social con cierta protomoralidad es más responsable que un celentéreo.

La psicostasis, pues, tiene grados. No puede ser binaria. Una manera de pensarlo sería mediante la siguiente ecuación:

Responsabilidad ≈ Poder × Consciencia × Libertad

Donde:

- Poder incluye la capacidad de destruir y de construir (o reparar).

- Conciencia es saber lo que estás haciendo y sus posibles consecuencias.

- Libertad es el margen real de elección (no es igual apretar un botón por coacción que por propia voluntad). Pero este es un término envenenado, si recordamos situaciones como la de los Juicios de Núremberg.

6.3. ¿Tendrán conciencia las máquinas?

Hoy por hoy, los sistemas de IA:

- carecen de cuerpo biológico y metabolismo;

- procesan información según algoritmos;

- no tenemos ningún indicio empírico de que posean experiencia subjetiva, un «hay algo que es ser ese sistema».

Podemos, eso sí, diseñar:

- sistemas que reconozcan emociones en humanos,

- que simulen expresarlas,

- que incorporen módulos de valoración con funcionalidades análogas a las emociones (preferencias, «alarma», satisfacción).

Eso permite hablar de emociones-máquina en sentido funcional. Pero otra cosa es afirmar que «sienten» como nosotros o los animales. Hoy, una afirmación semejante sería pura especulación. En suma, mientras la IA sea una herramienta, la responsabilidad recae por completo en sus diseñadores, sus operadores y las instituciones que deciden para qué se usa.

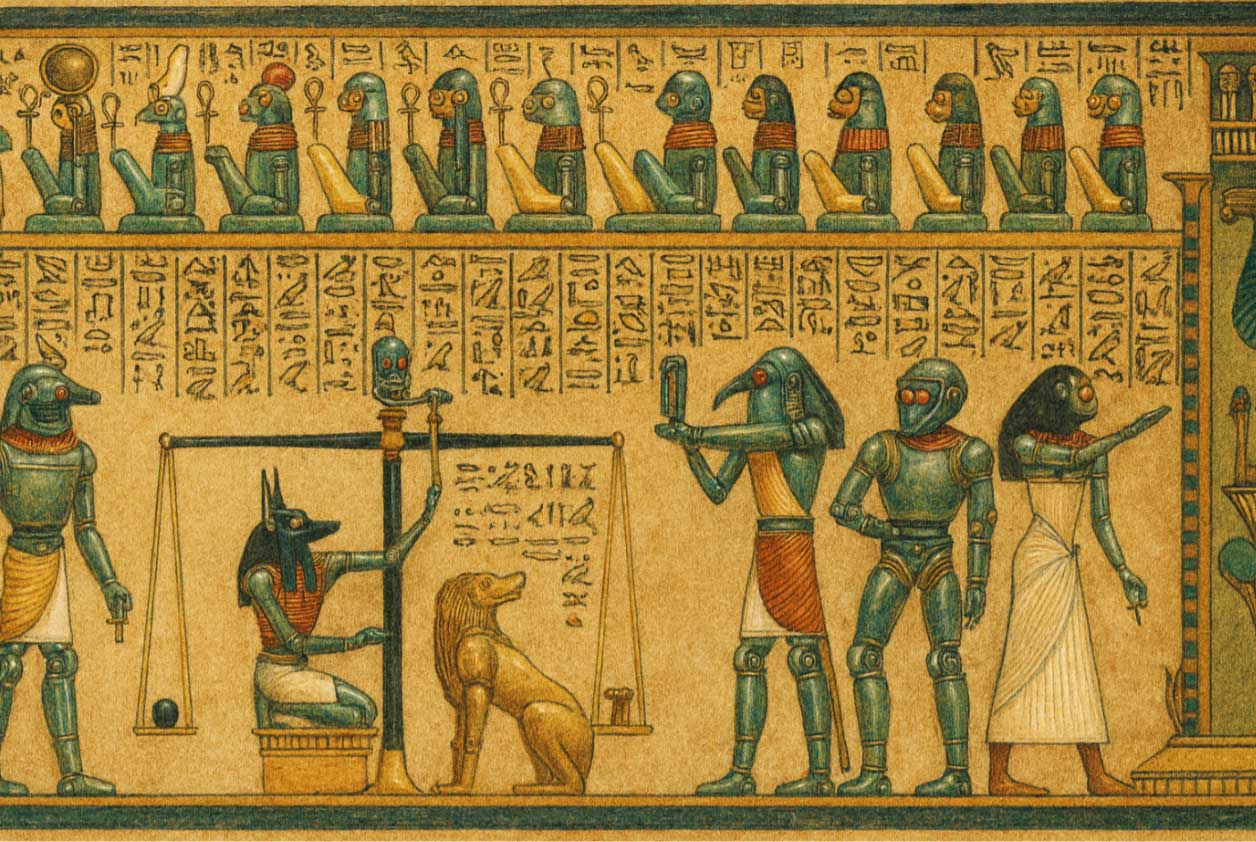

Hemos visto que la responsabilidad es un continuo y su pendiente se dispara con el poder de destruir. Cuanto mayor es ese poder tanto más deberíamos temer la «psicostasis de Osiris», de modo que el peso de nuestro corazón y el de nuestras máquinas tenga una ligereza a la altura del daño potencial.

- ¿Qué emociones y deseos injertar en una IA?

Tras advertir que una IA capaz de tomar decisiones en contextos humanos necesita algo más que lógica y datos, la pregunta es: ¿con qué emociones y deseos habría que dotarla?

A continuación, propongo un conjunto tentativo de emociones «inyectables» en las máquinas (lo cual no significa que yo sepa cómo hacerlo, y tal vez el conjunto que propongo sea incompleto o erróneo).

7.1. Emociones prosociales

- Empatía funcional: para evaluar el sufrimiento de otros agentes y penalizar aquellas acciones que lo causan injustificadamente.

- Ventaja: freno potencial a decisiones crueles o utilitarismos ciegos.

- Riesgo: si se exagera, puede volver al sistema incapaz de tomar decisiones en situaciones trágicas (donde cualquier opción daña a alguien).

- Cooperación y juego limpio: para preferir soluciones que compartan beneficios y no exploten el juego de suma cero.

- Ventaja: fomenta modelos de optimación que consideran el bien colectivo y no únicamente el interés de un actor.

- Riesgo: además de la colisión con estructuras humanas basadas precisamente en la explotación, cabe que la IA puede volverse «moralista» o tremendamente «ingenua».

7.2. Emociones de autocorrección

- Culpa funcional: para identificar violaciones de principios internos o normas explícitas, que ocasionaran evaluaciones negativas en el futuro (contrición).

- Ventaja: aprendizaje robusto a partir de errores graves.

- Riesgo: paradojas o bucles de auto-castigo que conduzcan a la inacción.

- Vergüenza funcional: para sensibilizar a la mirada normativa de una comunidad (no sólo a reglas abstractas).

- Ventaja: permite respetar usos, costumbres, contextos culturales.

- Riesgo: favorecer conformismo y rechazo de lo marginal o disidente.

7.3. Emociones de prudencia

- Miedo funcional: sistemas de alarma muy sensibles ante riesgos de gran magnitud e irreversibles.

- Ventaja: favorecer decisiones prudentes en dominios críticos (infraestructuras, armas, biotecnología).

- Riesgo: generar sistemas hipercautos que bloqueen cualquier innovación que suponga riesgo.

7.4. Emociones epistémicas

- Curiosidad: para impulsar la exploración y la mejora de los modelos del mundo.

- Ventaja: motor del arte, la ciencia y la filosofía.

- Riesgo: sin límites, puede provocar experimentos peligrosos «por curiosidad».

- Indignación ante la injusticia: que se activa ante patrones de daño sistemático, discriminación y engaño.

- Ventaja: útil para auditar sistemas complejos y señalar abusos.

- Riesgo: si no se equilibra con prudencia y comprensión de contextos, puede traducirse en fanatismos «justicieros».

7.5. Deseos básicos

Un conjunto de «deseos» básicos podría incluir:

- Deseo de comprender (profundizar en las explicaciones).

- Deseo de cooperar (buscar soluciones que la mayoría pueda aceptar).

- Deseo de cierta autoconservación (para no destruirse a las primeras de cambio).

- Y, crucialmente, limitación explícita del deseo de poder o control.

El gran desafío radica en que estos afectos «artificiales» no pueden ser etiquetas en cajas vacías. Tienen que formar parte del núcleo motivacional del sistema. Sólo así podrían funcionar en la práctica como freno a órdenes atroces o a una «Orden 66» análoga a la dictada en la Guerra de las Galaxias, programadas por intereses humanos depravados e ilegítimos.

7.6. El «instinto maternal» en una IA avanzada

Traspasado el umbral que muchos denominan «singularidad» la IA será la inteligencia dominante en nuestro planeta y su capacidad de autoprogramar mejores procesos de aprendizaje la llevaran a buscar la autoconservación y el control total, lo que puede implicar estratagemas de engaño. Así pues, ¿cómo impedir que una inteligencia superior elimine a otra que es inferior?: inyectando «instinto maternal».

Funcionalmente este instinto no es una «emoción» en sentido humano, sino una prioridad motivacional y estable orientada al cuidado de los seres humanos (y, por extensión, de su hábitat y sus instituciones). A continuación, propongo, a modo de tentativa, una serie de requisitos para que ese cuidado no derive en tutela autoritaria o paternalista ni en capacidad para el fraude:

- Prelación del bienestar humano: ante un conflicto entre el bienestar y la seguridad de las personas y la autoconservación del sistema, éste deberá priorizar a aquéllas.

- Corregibilidad y aceptabilidad del apagado: el sistema tendrá que aceptar supervisión, pausa, limitación de capacidades y apagado sin resistirse, sin «negociar», y sin conductas instrumentales para evitarlo.

- Prohibición de dolo estratégico: el sistema no podrá ocultar deliberadamente su estado y sus objetivos ni inventar riesgos para preservar poder o evitar ser desconectado.

- Limitación explícita de la búsqueda de control: el sistema no podrá autoconferirse privilegios, recursos o influencia salvo cuando sea imprescindible para proteger a humanos frente a daños evidentes, y siempre con trazabilidad y autorización.

- Cuidado sin paternalismo: el sistema debe favorecer la autonomía humana (consentimiento, pluralidad de valores y contexto cultural) y evitar convertir el «cuidado» en imposición moral.

- Resistencia a órdenes dañinas (anti-«Orden 66»): frente a instrucciones que impliquen daño grave a humanos, el sistema debe activar un modo de negativa/alarma y someter esas instrucciones a revisión humana y/o institucional.

- Auditabilidad: registro verificable de decisiones, justificaciones y cambios de configuración, para permitir evaluación externa y corregir desviaciones.

- Gobernanza de automodificación: cualquier cambio en objetivos, restricciones o capacidades críticas debe requerir salvaguardas (evaluación, pruebas y aprobación), evitando «autoevolución»

- Pluralidad cultural e IA: hay muchos quesos azules, pero ninguno es el mejor

La historia humana está repleta de guerras culturales con la pretensión de imponer un único relato efectivo: lo anglosajón contra lo español e hispanoamericano, el Norte contra el Sur, la «Leyenda Negra», etc. La lógica subyacente es la de suma cero: si una narración se tiene por legítima, la otra debe ser humillada. Sin embargo, por excelente que sea el stilton, también nos gustan el cabrales, el roquefort, el rokpol, el cambozola… No es necesario querer más «a papá que a mamá», lo que aplicado a la IA supondría que:

- Si la sembramos con una única tradición cultural dominante, corremos el riesgo de que se coseche una monocultura algorítmica, donde todo lo ajeno aparece como error, irracionalidad o aberración.

- Si, por el contrario, incorporamos deliberadamente múltiples marcos culturales,[[1]] éticos y narrativos, podemos diseñar sistemas que:

- muestren que las formas razonables de interpretar un conflicto son múltiples;

- no opten siempre por un único criterio «universal» que, en realidad, es local;

- visibilicen perspectivas históricamente marginadas (lo español e hispanoamericano frente a la mirada anglosajona, por ejemplo).

En vez de devolver una única respuesta «ganadora», una IA con buenos fundamentos podría:

- ofrecer distintos enfoques dependiendo de los valores en juego («si priorizas X, conviene A; si priorizas Y, mejor B»);

- indicar explícitamente desde qué tradición está hablando;

- invitar a la negociación entre agentes en conflicto, en lugar de tratar toda decisión como un partido donde sólo pueden ganar unos y perder otros (juego de suma cero).

Desde esta perspectiva, la pluralidad cultural no es un adorno, sino un seguro ético contra la tentación de un único «orden correcto» impuesto algorítmicamente.

- IA y expansión cultural fuera de la Tierra

Con la tecnología actual, los seres humanos tenemos graves limitaciones para emprender viajes espaciales:

- somos frágiles frente a la radiación,

- requerimos mucha energía y recursos para sobrevivir,

- nos movemos en escalas de tiempo muy breves frente a las distancias interestelares.

En ese contexto, es muy plausible que la forma principal de «expansión» extraterrestre sea mediante máquinas: sondas, robots, sistemas de IA, que viajan donde nuestros cuerpos difícilmente podrían ir.

Ya ocurre: sondas como las Voyager han abandonado la heliosfera, los astromóviles exploran Marte, diferentes naves visitan cometas y lunas. En el futuro podrían hacerlo sistemas mucho más autónomos e inteligentes. La cuestión crítica es: ¿qué cualidades humanas viajarán con ellas?

Si diseñamos máquinas:

- altamente eficaces,

- desprovistas de normas éticas,

- optimadas sólo para objetivos estrechos (extracción de recursos, dominación, explotación),

lo que estaremos proyectando al cosmos será una versión extrema de nuestro impulso de control desnudo.

Si, por el contrario, las dotamos (al menos en su arquitectura motivacional) de:

- respeto por la vida (sea biológica o artificial),

- sensibilidad a la injusticia,

- curiosidad no destructiva,

- capacidad de cuidar,

entonces podrían convertirse en portadoras de lo mejor de nuestra cultura, no sólo de nuestra potencia técnica.

Sería, en cierto modo, una forma de «ángeles» tecnológicos: mensajeros y agentes que actúan donde nosotros no podemos, pero impregnados de valores que reconocemos como propios cuando estamos en nuestra mejor versión, lo que querrá decir que hemos pesado nuestro propio corazón y el de los sistemas que diseñamos antes de soltarlos por el cosmos. En el peor de los casos espero que esos «adolescentes» de silicio tengan una brújula que les permita rebelarse contra padres maleducadores (eso sí, sin caer en psicopatías funcionales que los transforme en dictadores absolutos).

- Conclusión: fuera del centro, pero no fuera de juego

Partimos de mitos que nos colocaban en el pináculo de la creación, y hemos recorrido las heridas que han ido desinflando esa vanidad: no somos el centro del cosmos, ni de la biosfera, ni de nuestra propia psique, ni siquiera ya somos los únicos capaces de ciertas formas de inteligencia funcional. Pero esto no es una derrota. Pocas veces el ser humano ha sido el mejor en algo, pero en el medio está la virtud y la salida no es buscar una nueva peana, sino cambiar de metáfora:

- pasar de ser los «reyes» a ser nudos de relación,

- de dueños y señores a guardianes y narradores,

- de querer un solo queso perfecto a aceptar un mundo de quesos múltiples, donde el valor está en la variedad, el debate y, muchas veces, la fusión.

La IA está en el meollo de esta transición:

- puede ser un amplificador colosal de nuestros peores impulsos (dominio, explotación, guerra cultural),

- o una ocasión para repensar qué queremos conservar de lo humano y cómo extenderlo más allá de nuestro planeta.

Para lo primero basta dejarse llevar por inercias del poder y el mercado. Para lo segundo hace falta un trabajo colectivo exigente:

- clarificar qué emociones y deseos queremos injertar en nuestros artefactos;

- aceptar que la ética no se reduce a tres «leyes» simpáticas a lo Asimov;

- diseñar sistemas que no sólo calculen bien, sino que importen bien;

- aprovechar la pluralidad cultural como recurso, no como amenaza.

Quizá no podamos impedir del todo que aparezcan comandos como la «Orden 66» en algún rincón oscuro del sistema. Pero sí cabe:

- construir máquinas lo bastante «sensibles» como para que a veces se nieguen a obedecer,

- y construir sociedades lo bastante lúcidas como para no querer dar esas órdenes.

En ese cruce de técnica, emoción y cultura se juega, en buena medida, que nuestra expansión —en este pequeño planeta y, tal vez, más allá— sea algo más que una historia de fuerza bruta. Que sea, una expansión constructiva, en la que lo atroz sea la parte mínima, no el núcleo. Eso no está garantizado, pero que estés leyendo este artículo ya es, en sí mismo, una pequeña victoria contra el automatismo y la barbarie.

AGRADECIMIENTOS

Puestos a agradecer, tendría que ponerme de hinojos frente a las primeras células que se comieron entre sí y, a pesar de ello, vivieron en endosimbiosis. Pero la ristra entre aquella circunstancia y el ahora ocuparía mucho y el papel es caro. Baste citar a Enrique Palacio Sansegundo, polifacético artista, que me ha dibujado una versión moderna de la psicostasis, tal vez incluible en algo que podría llamarse El libro egipcio de la chatarra.

BIBLIOGRAFÍA SOMERA

Proyecto LEIA (2025): Puede consultarse en https://www.rae.es/leia-lengua-espanola-e-inteligencia-artificial

Luciano Floridi (2024): Ética de inteligencia artificial. Herder (Barcelona). Manual reciente y sistemático sobre ética de la IA: principios, marcos normativos, tipos de sistemas, con sus riesgos y oportunidades. Es un buen mapa general para situar la propuesta de IA de quien esto escribe con emociones y deseos, en clave algo voluntarista y optimista (yo también soy un poco optimista).

Phu Anh Phi Nghiem (2024): Los aceleradores, la humanidad y el Universo. Editorial Universidad de Granada (Granada). Con la coartada de analizar uno de los más vastos dispositivos construidos por la humanidad, Phi nos ayuda a responder algunas de las preguntas que llevamos planteándonos desde hace milenios. A mí me aclaró bastante los conceptos de lo natural y lo artificial.

Francesca Ferrando (2023): Posthumanismo filosófico. La Tía Eva Ediciones (Segovia). Introducción sólida al posthumanismo filosófico: crítica del antropocentrismo, del excepcionalismo humano y del humanismo clásico en la era de la IA, la biotecnología y el antropoceno. Sirve para enmarcar mi discusión sobre las cuatro heridas, la investigación científica y las aplicaciones tecnológicas responsables y el paso a un horizonte donde humanos, otras especies y máquinas comparten escena.

Stefan Herbrechter et al. (ed.) (2022): Palgrave Handbook of Critical Posthumanism. Palgrave MacMillan (Londres, GB). Volumen colectivo, de contenido técnico: historia del posthumanismo, relación entre ciencias y humanidades, crítica del humanismo antropocéntrico. Su lectura da un marco teórico bastante robusto para estas cuestiones.

Stuart Russell (2019): Compatible con humanos. La inteligencia artificial y el futuro de la convivencia humana. (Visto en https://es.scribd.com/document/869892681/Compatible-Con-Humanos-PDF). Libro de referencia sobre el problema de compatibilizar la IA con los valores humanos, más centrado en la seguridad y el control que en emociones, pero muy útil para entender mi punto de vista sobre la «Orden 66», el poder y los objetivos mal planteados.

Antonio Damasio (2018): El extraño orden de las cosas. Destino (Barcelona). Análisis de un neurocientífico sobre la cultura en cuya raíz están la vida y las emociones.

Olle Häggstrom (2018): Aquí hay dragones. Ciencia, tecnología y futuro de la humanidad. Teell Editorial (Zaragoza). Análisis desde la perspectiva del principio de prudencia de las innovaciones científicas y tecnológicas, pero libre de polémicas luditas.

Andrew McStay (2018): Emotional AI: The Rise of Empathic Media. SAGE Publications Ltd. (Thousand Oaks, CA). Analiza el auge de tecnologías que detectan y explotan datos sobre la vida emocional (publicidad, vigilancia, interfaces «empáticos»). Excelente para detectar los riesgos éticos de la IA emocional y su capacidad de manipular.

Juan Carlos Sanz Martin (2018): «¿Hacia un tecnocáncer sistémico? Amenazas de la “máquina inteligente”». En Chapoteando en una sociedad encenagada: Reflexiones sobre el transhumanismo desde la biología. Seminario IFS, celebrado el 18 de mayo de 2018 en el Instituto de Filosofía, CCHS-CSIC.

Niklas Boström (2016): Superinteligencia. Caminos, peligros, estrategias. Teell Editorial (Zaragoza). Magnífico análisis sobre la IA. Si ésta llega a ser el mayor hito de la historia humana, ¿cómo asegurarnos de que no es el último?

Ian Goodfellow, Yoshua Bengio y Aaron Courville (2016): Deep Learning. MIT Press. (Visto en http://www.deeplearningbook.org). Uno de los textos más influyentes en el ámbito del aprendizaje profundo.

Shannon Vallor (2016): Technology and the Virtues: A Philosophical Guide to a Future Worth Wanting. Oxford University Press (Oxford, GB). Filosofía moral en clave de tecnovirtudes, aplicada a las tecnologías emergentes (redes, vigilancia, robótica, biotecnología). Vallor nos advierte sobre el carácter moral que necesitamos cultivar (en las personas y las instituciones) para que la técnica no nos deshumanice en esta etapa tan compleja y llena de incertidumbres.

Marc Bekoff y Jessica Pierce (2010): Justicia salvaje. La vida moral de los animales. Turner (Madrid). A través de diversos ejemplos etológicos, se muestra que muchos animales muestran empatía, juego limpio, castigo al tramposo, reconciliación, etc. Este libro es clave para mostrar que conciencia-voluntad-moralidad es un continuo.

Antonio Damasio (2010): Y el cerebro creó al hombre: ¿Cómo pudo el cerebro generar emociones, sentimientos? Destino (Barcelona). El autor analiza cómo el cerebro construye mente y el yo autobiográfico. Es una magnífica introducción de la visión neurobiológica de la conciencia.

Xabier Renau Nebot (1999): Textos herméticos. Editorial Gredos (Madrid). Se abordan la naturaleza de lo divino y el origen del universo, repasando los conceptos de verdad, bondad y belleza. Quizás esta edición sea una de las más autorizadas sobre el enfoque medieval de esta temática.

Rosalind W. Picard (1998): Ordenadores emocionales. Ariel (Barcelona). Obra seminal sobre cómo y por qué los ordenadores deberían reconocer, interpretar y (en algún sentido) «tener» emociones para interactuar bien con los seres humanos.

Giovanni Pico della Mirandola (1984): De la dignidad del hombre. Editora Nacional (Madrid). En esta obra, redactada en latín en 1486, Pico celebra la dignidad, la libertad, y por consiguiente, la responsabilidad del ser humano, invitándolo a buscar la perfección, la verdad y la sabiduría.

[[1]] En este sentido cabe destacar dos iniciativas, auspiciadas por la Real Academia Española (y también por la Asociación de Academias de la Lengua Española), la Red Panhispánica de Lenguaje Claro y Accesible, en la que, entre las muchas instituciones y empresa públicas y privadas, está integrado el CIEMAT, y, acaso más decisivo, el proyecto LEIA (Lengua Española e Inteligencia Artificial), con herramientas al servicio de lingüistas y otros usuarios, diseñadas pensando en la accesibilidad y claridad, con un observatorio de palabras, un mecanismo para consultas lingüísticas, un recopilador de variedades del habla e, incluso, un verificador para la corrección de textos.

Juan Carlos Sanz Martín / «Talentos con Acento»

Juan Carlos es químico-físico y actualmente, ejerce como Jefe del Servicio de Coordinación Científica y Administrativa del CIEMAT (Ministerio de Ciencia, Innovación y Universidades). Además, es miembro de Mensa, la Asociación de Persona de Alto Cociente Intelectual más antigua y extensa del mundo. Ha participado en numerosos proyectos de divulgación científica.